Apple hat nun offiziell angekündigt, eine Reihe von Funktionen integrieren zu wollen, die darauf abzielen, Kinder online zu schützen, einschließlich eines Systems, das Material von Kindesmissbrauch in iCloud erkennen kann während die Privatsphäre der Nutzer gewahrt bleibt.

Der Tech-Gigant aus Cupertino kündigte am Donnerstagabend neue Kindersicherheitsfunktionen in drei Bereichen an, die helfen sollen, Kinder zu schützen und die Verbreitung von „Child Sexual Abuse Material“ (CSAM) einzuschränken. Die offizielle Ankündigung erfolgte nur Stunden später, nachdem Gerüchte dokumentiert wurden, wonach Apple eine Art System zur Eindämmung von CSAM auf seinen Plattformen einführen möchte.

Bei Apple ist es unser Ziel, Technologie zu entwickeln, die Menschen befähigt und ihr Leben bereichert – während sie ihnen hilft, sicher zu bleiben.

Neues System verwendet kryptografische Techniken

Apple wird beispielsweise neue Werkzeuge in Nachrichten implementieren, die es Eltern ermöglichen, besser darüber informiert zu sein, wie ihre Kinder online kommunizieren. Das Unternehmen setzt außerdem ein neues System ein, das kryptografische Techniken nutzt, um Sammlungen von CSAM, die in iCloud Fotos gespeichert sind, zu erkennen und Informationen an die Strafverfolgungsbehörden weiterzugeben. Apple arbeitet auch an neuen Sicherheitswerkzeugen in Siri und der Suche. So äußerte sich John Clark, CEO und Präsident des National Center for Missing & Exploited Children, wie folgt:

Da so viele Menschen Apple Produkte nutzen, haben diese neuen Sicherheitsmaßnahmen ein lebensrettendes Potenzial für Kinder, die online verführt werden und deren schreckliche Bilder im Bereich des sexuellen Kindesmissbrauchs in Umlauf gebracht werden. Im National Center for Missing & Exploited Children wissen wir, dass dieses Verbrechen nur bekämpft werden kann, wenn wir uns unerschütterlich für den Schutz der Kinder einsetzen. Wir können dies nur tun, weil Technologiepartner, wie Apple, aufstehen und ihr Engagement bekannt machen. Die Realität ist, dass Privatsphäre und Kinderschutz nebeneinander existieren können. Wir applaudieren Apple und freuen uns darauf, gemeinsam daran zu arbeiten, diese Welt zu einem sichereren Ort für Kinder zu machen.

Alle drei Funktionen wurden auch für den Datenschutz optimiert, um sicherzustellen, dass Apple Informationen über kriminelle Aktivitäten an die richtigen Behörden weitergeben kann, ohne die privaten Informationen gesetzestreuer Nutzer zu gefährden. Nachfolgend ein Überblick.

CSAM-Erkennung in iCloud Fotos

Die wichtigste neue Kindersicherheitsfunktion, die Apple implementieren möchte, konzentriert sich auf die Erkennung von CSAM innerhalb von iCloud Fotos. Wenn Apple Sammlungen von CSAM entdeckt, die in iCloud gespeichert sind, wird das Unternehmen diesen Account markieren und Informationen an die NCMEC weiterleiten, die als Meldestelle für Kindesmissbrauchsmaterial fungiert und mit Strafverfolgungsbehörden in den USA zusammenarbeitet. Doch Apple scannt hier nicht wirklich jedes einzelne Bild. Stattdessen werden die Informationen auf dem Gerät genutzt, um CSAM mit einer bekannten Datenbank von Hashes abzugleichen, die von der NCMEC und anderen Kinderschutzorganisationen bereitgestellt werden.

iCloud Fotos: Nach automatischer Markierung erfolgt eine manuelle Überprüfung

Diese Datenbank wird in einen unlesbaren Satz von Hashes umgewandelt, die sicher auf dem Gerät des Nutzers gespeichert werden. Die eigentliche Methode zur Erkennung von CSAM in iCloud Fotos ist kompliziert und verwendet bei jedem Schritt kryptographische Techniken, um die Genauigkeit zu gewährleisten und gleichzeitig die Privatsphäre des durchschnittlichen Nutzers zu wahren. Apple sagt, dass ein markierter Account nach einem manuellen Überprüfungsprozess deaktiviert wird, um sicherzustellen, dass es sich um einen echten positiven Fall handelt. Nachdem ein Konto deaktiviert wurde, wird das Unternehmen aus Cupertino die NCMEC informieren. Nutzer haben die Möglichkeit, gegen die Sperrung Einspruch zu erheben, wenn sie das Gefühl haben, dass sie fälschlicherweise beschuldigt wurden. Das Unternehmen betont, dass das Feature nur CSAM erkennt, die in iCloud Fotos gespeichert sind.

Apple: Das Tool scannt nur nach CSAM in iCloud Fotos

Es wird nicht für Fotos gelten, die ausschließlich auf dem Gerät gespeichert sind. Außerdem behauptet Apple, dass das System eine Fehlerquote von weniger als einem von einer Billion Konten pro Jahr hat. Anstatt cloudbasiert zu scannen, meldet das Feature auch nur Nutzer, die eine Sammlung von bekannten CSAM in iCloud gespeichert haben. Ein einzelnes Bild reicht also nicht aus, um die Funktion auszulösen, was dazu beiträgt, die Rate der Fehlalarme zu reduzieren. Auch hier gibt Apple an, dass es nur über Bilder informiert wird, die mit bekannten CSAM übereinstimmen. Es scannt nicht jedes Bild, das in der iCloud gespeichert ist und wird keine Bilder erhalten oder ansehen, die nicht mit bekannten CSAM übereinstimmen. Das CSAM-Erkennungssystem wird zunächst nur für iCloud-Konten in den USA gelten. Doch das Unternehmen erklärt, dass es das System in Zukunft wahrscheinlich in einem größeren Umfang ausrollen wird.

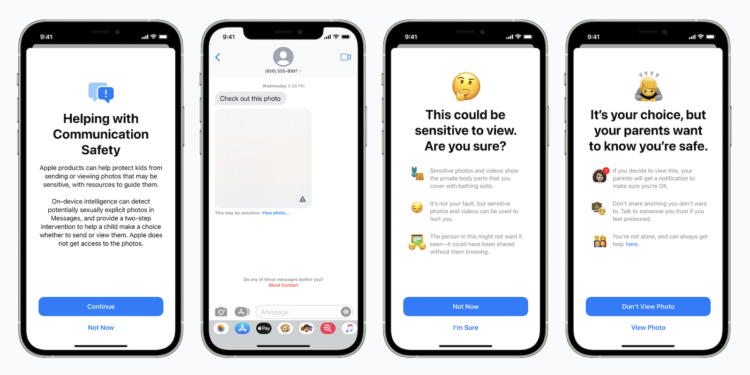

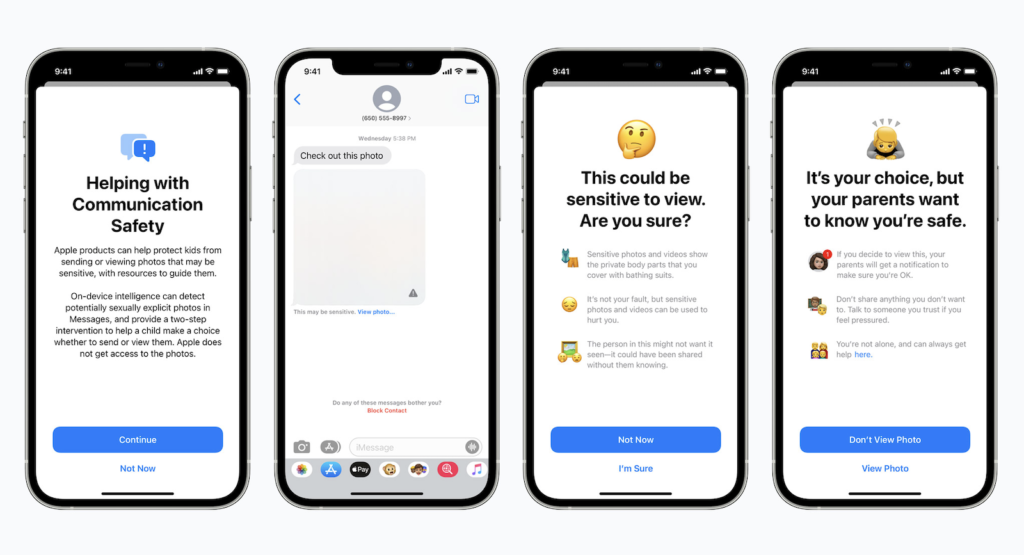

iMessage: Sichere Kommunikation in iMessage

Ein zweites neues Feature konzentriert sich auf die Erhöhung der Sicherheit von Kindern, die online über Apples iMessage kommunizieren. So wird die iMessage App nun Warnungen für Kinder und Eltern anzeigen, wenn sie sexuell eindeutige Bilder empfangen oder senden. Wenn ein Kind ein sensibles Bild erhält, wird es automatisch unscharf dargestellt und dem Kind werden hilfreiche Ressourcen präsentiert. Apple hat auch einen Mechanismus eingebaut, der Kinder wissen lässt, dass eine Nachricht an ihre Eltern versendet wird, wenn sie das Bild doch ansehen. Das System nutzt maschinelles Lernen auf dem Gerät, um Bilder zu analysieren und festzustellen, ob sie sexuell explizit sind. Es ist so konzipiert, dass Apple keine Kopie des Bildes erhält.

Auch Siri & Suche wird angepasst

Zusätzlich zu den iMessage Sicherheitsfunktionen erweitert Apple auch die Werkzeuge und Ressourcen, die es in Siri & Suche anbietet, wenn es um die Sicherheit von Kindern im Internet geht. So werden beispielsweise iPhone- und iPad-Nutzer in der Lage sein, Siri zu fragen, wie sie CSAM oder Child Exploitable melden können. Siri wird dann die entsprechenden Ressourcen und Anleitungen zur Verfügung stellen.

Apple: Die Privatsphäre wird gewahrt

Apple hat lange damit geworben, dass es sich große Mühe gibt, die Privatsphäre der Nutzer zu schützen. Das Unternehmen hat sich sogar schon mit den Strafverfolgungsbehörden über die Datenschutzrechte der Nutzer gestritten. Aus diesem Grund hat die Einführung eines Systems, das Informationen an die Strafverfolgungsbehörden weitergeben soll, einige Sicherheitsexperten beunruhigt. Cupertino behauptet allerdings, dass die Überwachung und der Missbrauch des Systems ein „Hauptanliegen“ bei der Entwicklung war. Jede Funktion wurde so entworfen, dass die Privatsphäre gewahrt bleibt und gleichzeitig CSAM oder Kinderausbeutung im Internet bekämpft wird – so Apple.

CSAM-Erkennungssystem kann nur entsprechendes Material erkennen

Das CSAM-Erkennungssystem wurde von Anfang an so konzipiert, dass es nur CSAM erkennt – es enthält keine Mechanismen zur Analyse oder Erkennung anderer Arten von Fotos. Außerdem erkennt es nur Sammlungen von CSAM über einem bestimmten Schwellenwert. Auch die Verschlüsselung bleibt von dem Erkennungssystem unberührt. Trotz all dem sind Sicherheitsexperten noch immer über die möglichen Auswirkungen besorgt. Matthew Green, ein Professor für Kryptographie an der Johns Hopkins University, merkt an, dass die Hashes auf einer Datenbank basieren, die der Nutzer nicht einsehen kann. Darüber hinaus besteht die Möglichkeit, dass Hashes missbraucht werden können – etwa wenn ein harmloses Bild einen Hash mit bekannter CSAM teilt. So schreibt er:

Die Idee, dass Apple ein Datenschutz-Unternehmen ist, hat ihnen eine Menge gute Presse eingebracht. Aber es ist wichtig, sich daran zu erinnern, dass dies dasselbe Unternehmen ist, das deine iCloud-Backups nicht verschlüsselt, weil das FBI Druck auf sie ausgeübt hat.

Die neuen Features werden unter iOS 15, iPadOS 15, watchOS 8 und macOS 12 Monterey noch in diesem Herbst eingeführt. Wie bereits oben erwähnt, sind sie vorerst nur auf die USA beschränkt. (Bild: Apple)