Apple hat gestern neue CSAM-Erkennungstechniken angekündigt und verursachte damit große Diskussionen. Leider kam es dabei auch zu Verwirrungen. Im Gegensatz zu dem, was einige Leute glauben, kann Apple keine Bilder überprüfen, wenn Nutzer iCloud-Fotos deaktiviert haben.

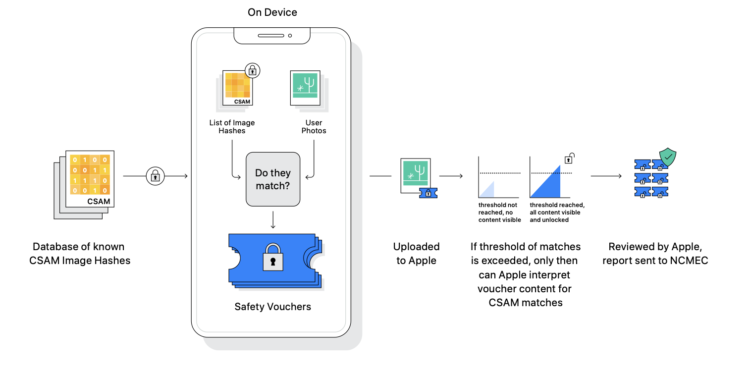

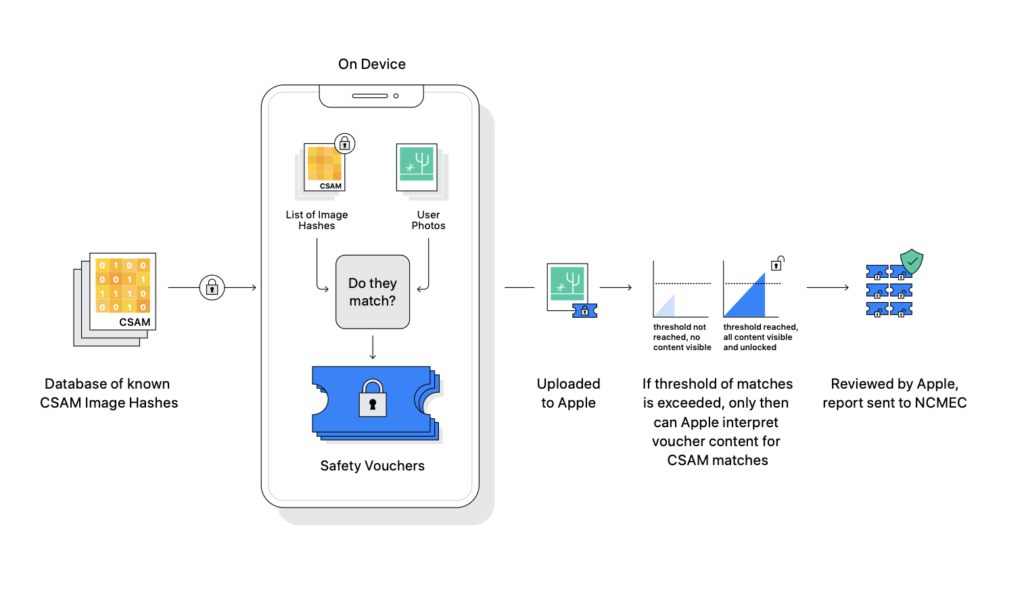

Obwohl in der Ankündigung eine umfangreiche Erklärung angehängt wurde, die einige Fragen beantwortet, sorgt Apples kommendes Feature trotzdem für Verwirrung. Zugegeben, es war auch eine große Menge an Input, weshalb ich das Update möglichst detailreich aufgeschlüsselt habe – basierend auf den Informationen, die Apple bereitgestellt hat. Wie dem auch sei. Nachfolgend schlüsseln wir nochmal den Prozess des Abgleichs auf.

Erkennungstechnik wird unter iOS 15 und Co. eingeführt

Apple wird mit iOS 15, iPadOS 15, watchOS 8 und macOS 12 Monterey eine für den Nutzer unlesbare Datenbank mit bekannten CSAM-Bilder-Hashes (Child Sexual Abuse Material, CSAM) auf die Geräte laden, wodurch die Bilder eines Nutzers abgeglichen werden. Der Abgleich findet allerdings erst dann statt, wenn die lokalen Bilder in die iCloud-Foto-Mediathek hochgeladen werden – also unmittelbar vor dem Upload. Apple zufolge sei es eine sehr genaue Methode, um CSAM zu erkennen und Kinder zu schützen. Das Scannen von CSAM-Bildern ist dabei keine optionale Funktion und geschieht also automatisch.

Gegen Kindesmissbrauch: Prüfung auf CSAM-Inhalte blockieren

Doch sie kann deaktiviert werden. So hat Apple gegenüber MacRumors bestätigt, dass es keine bekannten CSAM-Bilder erkennen kann, wenn die iCloud-Fotos-Funktion ausgeschaltet ist. Die Methode funktioniert, indem sie ein bekanntes CSAM-Foto auf dem Gerät identifiziert und es dann markiert, bevor es in iCloud-Fotos hochgeladen wird. Nachdem eine bestimmte Anzahl von solchen Zertifikaten (aka markierte Fotos) in iCloud-Fotos hochgeladen wurden, bekommt Apple eine direkte Warnung. Erst dann wird eine manuelle Überprüfung durchgeführt. Wenn tatsächlich CSAM-Inhalte gefunden werden, wird das Benutzerkonto deaktiviert und das National Center for Missing and Exploited Children benachrichtigt. Diese amerikanische Nichtregierungsorganisation wird im Anschluss die Strafverfolgungsbehörden kontaktieren. Übrigens, Apple hat auch bestätigt, dass es keine bekannten CSAM-Bilder in iCloud-Backups erkennen kann, wenn iCloud-Fotos auf dem Gerät eines Nutzers deaktiviert ist.

Apples neue Kinderschutzfunktionen: Sicherheitsforscher zeigen sich besorgt

Wer also prinzipiell einen Abgleich verhindern möchte, der muss iCloud-Fotos in den Systemeinstellungen deaktivieren. Im Übrigen möchte ich an dieser Stelle einmal mehr daran erinnern, dass diese neue Erkennungstechnik nach Hashes von bekanntem Material über sexuellen Kindesmissbrauch sucht und nicht allgemein die Fotobibliothek eines Nutzers durchleuchtet. Das heißt auch, dass andere Inhalte nicht erkannt werden. Außerdem werden nur Bilder und keine Videos überprüft. Aber: Sicherheitsforscher haben bereits Bedenken über Apples CSAM-Initiative geäußert und befürchten, dass sie in Zukunft in der Lage sein könnte, andere Arten von Inhalten zu erkennen, die politische und sicherheitsrelevante Auswirkungen haben könnten. Doch für den Moment sind Apples Bemühungen auf die Suche nach Kinderschändern beschränkt. Wer mehr über Apples neue Initiative erfahren möchte, der sollte sich den nachfolgenden Artikel genauer ansehen.

Hinweis:

Das neue Scan-Verfahren wird im Herbst ausgerollt und wird vorerst auf die USA beschränkt sein. Eine Ausweitung soll allerdings erfolgen. (Bild: Apple)