Anlässlich des „Global Accessibility Awareness Day“ hat Apple eine Reihe neuer Funktionen für iOS 16 angekündigt, die sich an gehörlose, schwerhörige, blinde oder sehbehinderte Nutzer von iPhone und Apple Watch richten.

Apple wurde bereits mehrfach für seine Arbeit im Bereich Barrierefreiheit ausgezeichnet. Nun hat das Unternehmen eine ganze Reihe von neuen Bedienungshilfen angekündigt, die „im Laufe dieses Jahres mit Software-Updates für alle Apple-Plattformen“ erscheinen werden. In der Pressemitteilung äußerte sich Sarah Herrlinger, Senior Director of Accessibility Policy and Initiatives bei Apple, wie folgt:

Wir sind bestrebt, die besten Produkte und Dienstleistungen für alle zu entwickeln. Wir freuen uns, diese neuen Funktionen einzuführen, die Innovation und Kreativität von Teams bei Apple vereinen, um den Nutzern mehr Möglichkeiten zu geben, unsere Produkte so zu nutzen, wie es ihren Bedürfnissen und ihrem Leben am besten entspricht.

Apple sagt, dass die neuen Funktionen maschinelles Lernen nutzen, um jedem zu helfen, „das Beste aus den Apple Produkten herauszuholen“. Apple hat zwar nicht angegeben, dass die neuen Funktionen Teil von iOS 16 sein werden aber es ist wahrscheinlich, dass die meisten dieser Neuerungen bei der Veröffentlichung im September oder Oktober Teil der neuen Software-Generation sein werden. Zu den Highlights der neuen Funktionen gehören die Türerkennung für Menschen mit Sehschwäche, die Erweiterung von VoiceOver und die Möglichkeit für hörgeschädigte Nutzer, Live-Untertitel zu sehen, was um sie herum gesprochen wird.

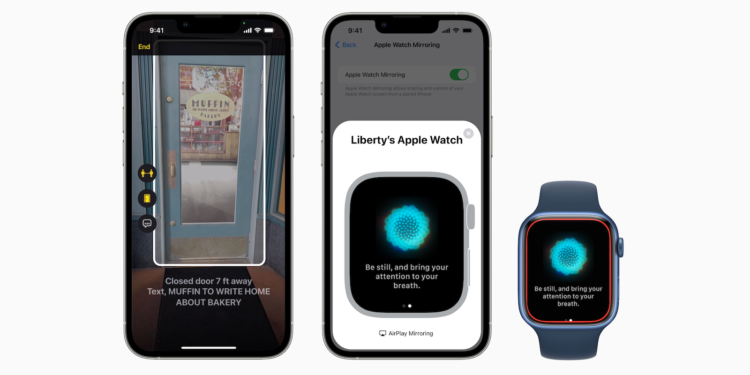

Türaufspürung

Die Türaufspürung ist laut Apple eine „hochmoderne Navigationsfunktion“. Sie findet automatisch Türen, „wenn du an einem neuen Ziel ankommst“ und zeigt nicht nur die Entfernung zu einer Tür an sondern beschreibt sie auch. Als Teil dieser neuen Funktion fügt Apple einen Erkennungsmodus zu Magnifier hinzu, Apples Control Center Tool zur Unterstützung von Menschen mit Sehschwäche. Dieser Erkennungsmodus nutzt Türerkennung, Personenerkennung und Bildbeschreibungen, um den Nutzern detaillierte Informationen über ihre Umgebung zu liefern. Die Funktion erfordert LiDAR, weshalb sie derzeit nur für das iPhone 12 Pro, iPhone 12 Pro Max, iPhone 13 Pro, iPhone 13 Pro Max und iPad Pro verfügbar ist.

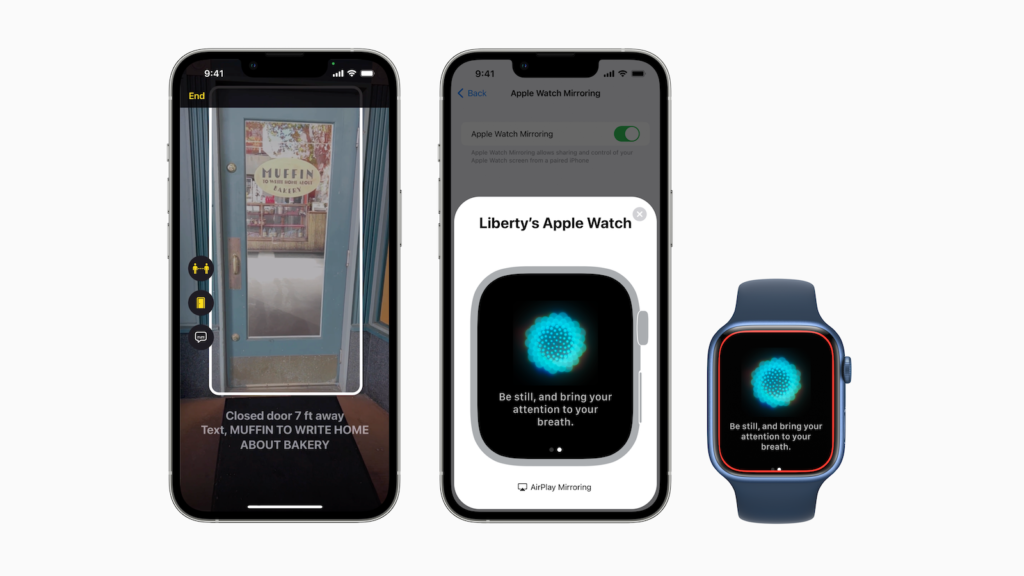

Physische und motorische Bedienungshilfen

Die neue Funktion Apple Watch Mirroring soll es Nutzern ermöglichen, „die Apple Watch aus der Ferne von ihrem gekoppelten iPhone aus zu steuern“. Das bedeutet, dass die Zugänglichkeits- oder Hilfsfunktionen des iPhones, wie z. B. die Sprachsteuerung, „als Alternative zum Tippen auf das Display der Apple Watch“ genutzt werden können. Apple baut außerdem auf der früheren AssistiveTouch-Funktion auf, mit der Nutzer die Apple Watch mit Gesten steuern konnten. „Mit den neuen Quick Actions auf der Apple Watch“, so Apple, „kann man mit einem Doppeldruck einen Anruf annehmen oder beenden, eine Benachrichtigung abweisen, ein Foto aufnehmen, Medien in der Now Playing App abspielen oder pausieren und ein Workout starten, pausieren oder fortsetzen.“

Live-Untertitel

Das Feature „Live-Untertitel“ wird im Laufe diesen Jahres in einer Beta-Version verfügbar sein und zunächst nur in den USA und Kanada unterstützt. Außerdem werden dafür das iPhone 11 oder neuer, iPads mit A12 Bionic-Prozessor oder neuer und Apple Silicon Macs benötigt. Mit der richtigen Hardware können Nutzer Live-Untertitel nutzen, um „jedem Audioinhalt einfacher zu folgen“, so Apple. Egal, ob sie ein Telefonat oder einen FaceTime-Anruf führen, eine Videokonferenz oder eine Social Media App nutzen, Medieninhalte streamen oder sich mit jemandem neben ihnen unterhalten. Während eines FaceTime-Gruppenanrufs ordnen die neuen Live-Untertitel die transkribierten Untertitel automatisch dem richtigen Anrufer zu, damit klar ist, wer was sagt. Auf dem Mac können Nutzer während eines Anrufs eine Antwort eintippen, die den anderen Gesprächsteilnehmern laut vorgelesen wird.

Weitere Funktionen

Neben diesen Hauptmerkmalen hat Apple auch eine Reihe von Einstellungen und Optionen angekündigt, die die Barrierefreiheit unterstützen sollen.

- Buddy Controller – kombiniert zwei Game Controller zu einem, so dass ein Freund oder eine Pflegeperson beim Spielen helfen kann.

- Siri Pausenzeit – Nutzer mit Sprachbehinderungen können einstellen, wie lange Siri wartet, bevor sie auf eine Anfrage antwortet.

- Sprachgesteuerter Rechtschreibmodus – ermöglicht es Nutzern, Buchstaben für Buchstaben zu diktieren, um eigene oder ungewöhnliche Wörter zu bilden.

- Geräuscherkennung – iPhones können so trainiert werden, dass sie den Hausalarm oder Anwendungen des Nutzers erkennen.

- Apple Books – die App fügt benutzerdefinierte Steuerelemente hinzu, mit denen sich Zeilen-, Zeichen- und Wortabstände feiner einstellen lassen.

Wer die vollständige Pressemitteilung einsehen möchte, der findest das Ganze hier. (Bild: Apple)