Apple hat nun ein Dokument veröffentlicht, das einen detaillierteren Überblick über die Kinderschutzfunktionen gibt, die vor zwei Wochen erstmals angekündigt wurden.

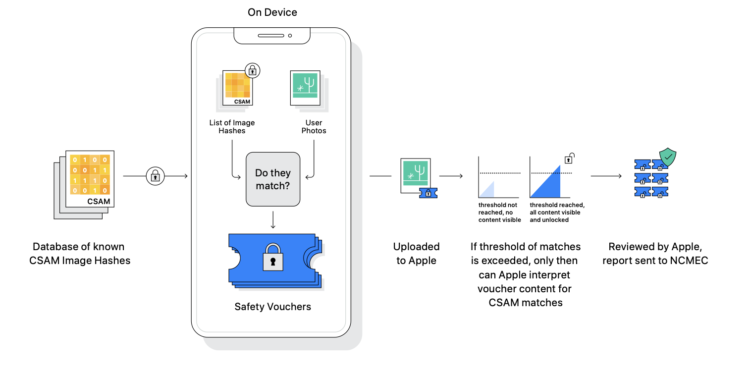

Apples Plan, bekannte Bilder von sexuellem Kindesmissbrauch (Child Sexual Abuse Material, CSAM), die in iCloud-Fotos gespeichert sind, zu erkennen, ist besonders umstritten und hat bei einigen Sicherheitsforschern, der gemeinnützigen Electronic Frontier Foundation und anderen Bedenken hervorgerufen, dass das System möglicherweise von Regierungen als eine Form der Massenüberwachung missbraucht werden könnte. Das neue Dokument zielt darauf ab, diese Bedenken zu adressieren und wiederholt einige Details, die zuvor in einem Interview mit Apples Softwareentwicklungschef Craig Federighi veröffentlicht wurden. Zum Beispiel muss ein iCloud-Account mindestens über 30 bekannte CSAM-Bilder verfügen, bevor eine manuelle Überprüfung angestoßen wird.

iCloud-Fotos: Apple erklärt Funktionsweise der Datenbank

Apple sagte auch, dass die Datenbank auf dem Gerät mit bekannten CSAM-Bildern nur Einträge enthält, die unabhängig voneinander von zwei oder mehr Kinderschutzorganisationen eingereicht wurden, die in separaten, souveränen Jurisdiktionen arbeiten und nicht unter der Kontrolle der gleichen Regierung stehen.

Das System ist so konzipiert, dass ein Nutzer weder Apple noch einer anderen einzelnen Organisation oder gar einer Reihe von möglicherweise zusammenarbeitenden Organisationen aus demselben Hoheitsgebiet (d.h. unter der Kontrolle derselben Regierung) vertrauen muss, um sicher zu sein, dass das System wie beworben funktioniert. Dies wird durch mehrere ineinandergreifende Mechanismen erreicht, einschließlich der inhärenten Überprüfbarkeit eines einzigen Software-Images, das weltweit für die Ausführung auf dem Gerät verteilt wird, einer Anforderung, dass alle Wahrnehmungsbild-Hashes, die in der verschlüsselten CSAM-Datenbank auf dem Gerät enthalten sind, unabhängig von zwei oder mehr Kinderschutzorganisationen aus verschiedenen souveränen Gerichtsbarkeiten zur Verfügung gestellt werden und schließlich einem menschlichen Überprüfungsprozess, um fehlerhafte Berichte zu verhindern.

Apple fügte hinzu, dass das Unternehmen ein Support-Dokument auf seiner Website veröffentlichen wird, das einen Root-Hash der verschlüsselten CSAM-Hash-Datenbank enthält, die in jeder Version jedes Apple-Betriebssystems enthalten ist, das diese Funktion unterstützt.

Apple-Mitarbeiter im Einzelhandel sollen auf FAQ zurückgreifen

Zusätzlich sagte Apple, dass Nutzer in der Lage sein werden, den Root-Hash der verschlüsselten Datenbank auf ihrem Gerät zu überprüfen und ihn mit dem erwarteten Root-Hash im Support-Dokument zu vergleichen. Ein Zeitrahmen hierfür wurde jedoch nicht genannt. In einem Memo, das Mark Gurman von Bloomberg zugespielt wurde, sagte Apple, dass es das System auch von einem unabhängigen Prüfer überprüfen lassen wird. In dem Memo wird darauf hingewiesen, dass Apple-Mitarbeiter im Einzelhandel möglicherweise Fragen von Kunden zu den Kinderschutzfunktionen erhalten und verweist auf eine FAQ, die Apple Anfang der Woche als Ressource veröffentlicht hat, die die Mitarbeiter nutzen können, um die Fragen zu beantworten und den Kunden mehr Klarheit und Transparenz zu bieten. (Bild: Apple)