Apple hat heute an einer Frage-und-Antwort-Runde mit Reportern bezüglich seiner neuen Kinderschutzfunktionen teilgenommen. Während der Befragung bestätigte Apple, dass das Unternehmen offen dafür ist, die Funktionen in Zukunft auf Drittanbieter-Apps auszuweiten.

Apple wird beispielsweise neue Werkzeuge in Nachrichten implementieren, die es Eltern ermöglichen, besser darüber informiert zu sein, wie ihre Kinder online kommunizieren. Das Unternehmen setzt außerdem ein neues System ein, das kryptografische Techniken nutzt, um Sammlungen von CSAM, die in iCloud-Fotos gespeichert sind, zu erkennen und Informationen an die Strafverfolgungsbehörden weiterzugeben. Apple arbeitet auch an neuen Sicherheitswerkzeugen in Siri und der Suche. Zur Erinnerung:

CSAM-Erkennung in iCloud-Fotos

Die wichtigste neue Kindersicherheitsfunktion, die Apple implementieren möchte, konzentriert sich auf die Erkennung von CSAM innerhalb von iCloud-Fotos. Wenn Apple Sammlungen von CSAM entdeckt, die in iCloud gespeichert sind, wird das Unternehmen diesen Account markieren und Informationen an die NCMEC weiterleiten, die als Meldestelle für Kindesmissbrauchsmaterial fungiert und mit Strafverfolgungsbehörden in den USA zusammenarbeitet. Doch Apple scannt hier nicht wirklich jedes einzelne Bild. Stattdessen werden die Informationen auf dem Gerät genutzt, um CSAM mit einer bekannten Datenbank von Hashes abzugleichen, die von der NCMEC und anderen Kinderschutzorganisationen bereitgestellt werden.

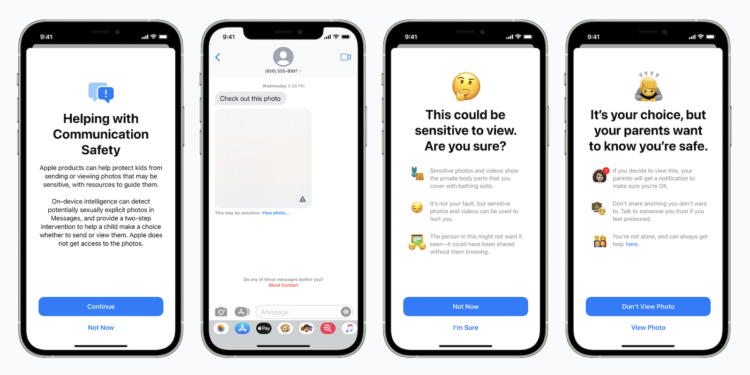

iMessage: Sichere Kommunikation in iMessage

Ein zweites neues Feature konzentriert sich auf die Erhöhung der Sicherheit von Kindern, die online über Apples iMessage kommunizieren. So wird die iMessage App nun Warnungen für Kinder und Eltern anzeigen, wenn sie sexuell eindeutige Bilder empfangen oder senden. Wenn ein Kind ein sensibles Bild erhält, wird es automatisch unscharf dargestellt und dem Kind werden hilfreiche Ressourcen präsentiert. Apple hat auch einen Mechanismus eingebaut, der Kinder wissen lässt, dass eine Nachricht an ihre Eltern versendet wird, wenn sie das Bild doch ansehen. Das System nutzt maschinelles Lernen auf dem Gerät, um Bilder zu analysieren und festzustellen, ob sie sexuell explizit sind. Es ist so konzipiert, dass Apple keine Kopie des Bildes erhält.

Auch Siri & Suche wird angepasst

Zusätzlich zu den iMessage Sicherheitsfunktionen erweitert Apple auch die Werkzeuge und Ressourcen, die es in Siri & Suche anbietet, wenn es um die Sicherheit von Kindern im Internet geht. So werden beispielsweise iPhone- und iPad-Nutzer in der Lage sein, Siri zu fragen, wie sie CSAM oder Child Exploitable melden können. Siri wird dann die entsprechenden Ressourcen und Anleitungen zur Verfügung stellen.

Ausweitung auf Apps von Drittanbietern

Nun hat Apple gegenüber Reportern erklärt, dass es zwar heute noch nichts anzukündigen hat aber eine Ausweitung der Kinderschutzfunktionen auf Drittanbieter ein wünschenswertes Ziel wäre, damit die Nutzer noch umfassender geschützt sind. Apple nannte keine konkreten Beispiele. Doch eine Möglichkeit wäre, dass die Kommunikations-Sicherheitsfunktion für Apps wie Snapchat, Instagram oder WhatsApp verfügbar gemacht wird, so dass sexuell eindeutige Fotos, die ein Kind erhält, unscharf werden. Eine andere Option ist, dass Apples bekanntes CSAM-Erkennungssystem auf Drittanbieter-Apps ausgeweitet wird, die Fotos an anderer Stelle als iCloud-Fotos hochladen. Das in Cupertino ansässige Unternehmen gab im Zuge dessen keinen Zeitrahmen an, wann die Kinderschutzfunktionen auf Drittanbieter ausgeweitet werden könnten, da das Unternehmen die Tests und den Einsatz der Funktionen noch abschließen muss. Apple erklärte dabei, dass es sicherstellen müsse, dass eine mögliche Ausweitung die Privatsphäre-Eigenschaften oder die Effektivität der Funktionen nicht untergraben würde. (Bild: Apple)