Apples jüngste Ankündigung zum Kinderschutz in Bezug auf die Bewertung von iCloud-Fotos und iMessage-Benachrichtigungen hat für eine Menge Diskussionen weltweit gesorgt. Neben Sicherheitsforschern und anderen Beobachtern diskutieren natürlich auch normale Anwender wie du und ich. Doch es gibt etwas, das wir alle beachten müssen. Trotz Apples neuer Funktion – die vorerst auf die USA beschränkt bleibt – ändert sich an Apples Datenschutzrichtlinien nichts. Nachfolgend beleuchten wir gemeinsam die wichtigsten Fragen und versuchen damit für mehr Klarheit zu sorgen.

Apple hat am 05. August 2021 eine neue Reihe von Werkzeugen angekündigt, die helfen sollen, Kinder online zu schützen und die Verbreitung von Material über sexuellen Kindesmissbrauch (Child Sexual Abuse Material, CSAM) einzudämmen. Dazu gehören neue Funktionen in iMessage, Siri und der Suche, sowie ein Mechanismus, der iCloud-Fotos nach bekannten CSAM-Bildern scannt.

CSAM-Scan: Reaktionen fallen unterschiedlich aus

Neben Fans haben auch Datenschutz- sowie Online-Sicherheitsexperten und andere Beobachter gemischt auf Apples Ankündigung reagiert. Doch interessanterweise unterschätzen viele, wie weit verbreitet die Praxis des Scannens von Bilddatenbanken nach CSAM tatsächlich ist. Apple ist hierbei gewiss nicht das erste Unternehmen auf dem Markt – es hat lediglich mehr Aufmerksamkeit auf sich gezogen. Darüber hinaus wird Apple den Schutz der Privatsphäre keinesfalls dadurch aufgeben. Also, legen wir los.

Apples Datenschutzfunktionen

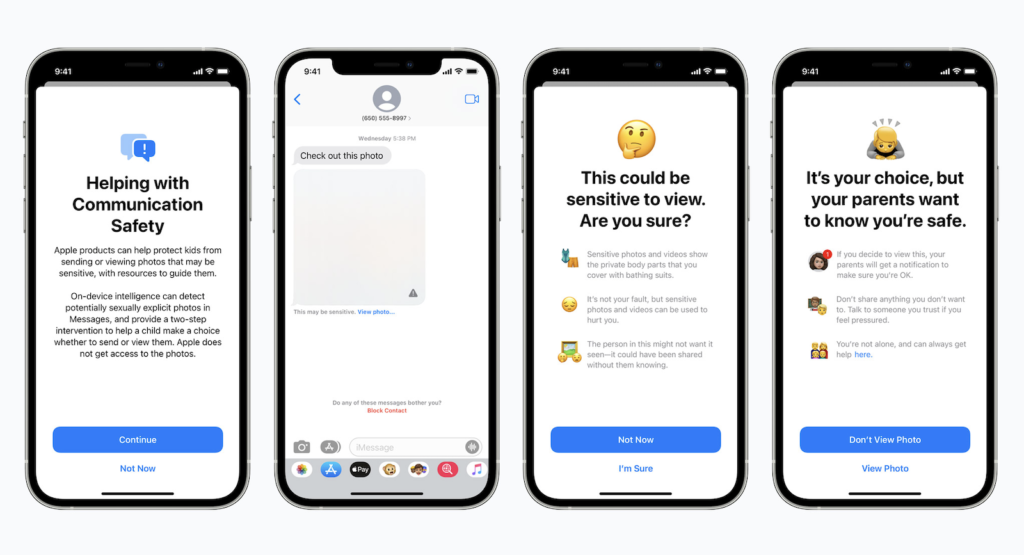

Die Palette der Kinderschutzfunktionen des Unternehmens umfasst das bereits erwähnte Scannen von iCloud-Fotos sowie aktualisierte Werkzeuge und Ressourcen in Siri und der Suche. Es beinhaltet auch ein Feature, das unangemessene Bilder, die über iMessage an oder von Minderjährigen empfangen bzw. versendet werden, kennzeichnen soll. Wie Apple in seiner ursprünglichen Ankündigung anmerkt, wurden alle Funktionen mit Blick auf den Datenschutz entwickelt. Sowohl das iMessage-Feature als auch der iCloud-Foto-Scan nutzen zum Beispiel die Intelligenz des Geräts.

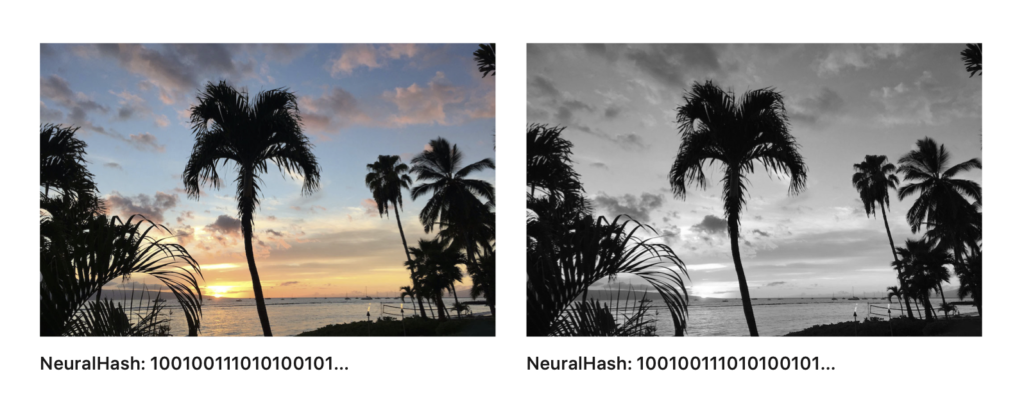

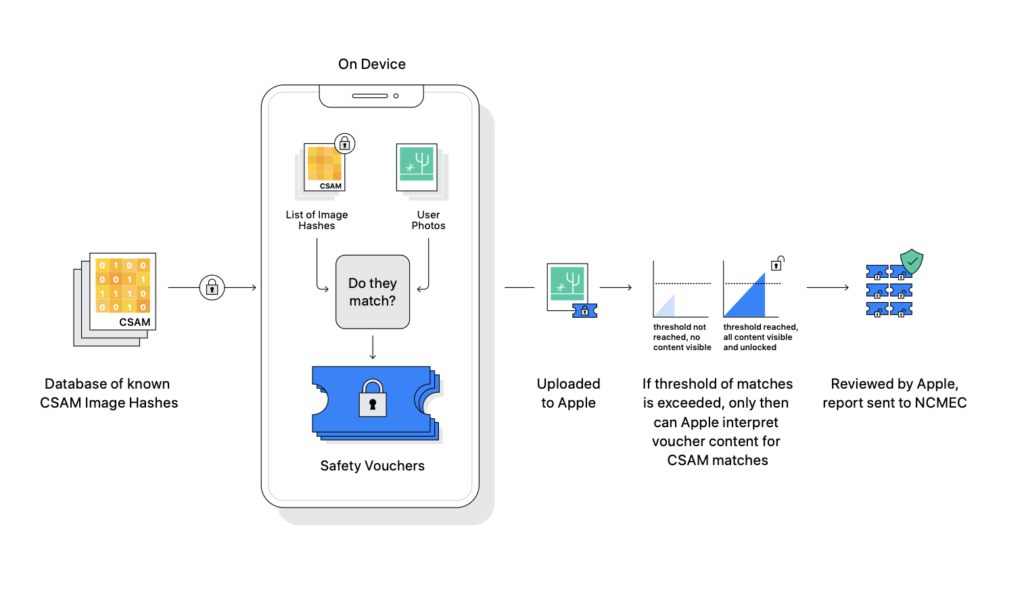

„Scanner“ vergleicht mathematische Hashes

Außerdem scannt bzw. analysiert der neue iCloud-Fotos „Scanner“ nicht wirklich die Bilder auf dem iPhone des Nutzers. Stattdessen vergleicht er die mathematischen Hashes von bekannten CSAM mit den in iCloud gespeicherten Bildern. Wenn eine Sammlung von bekannten CSAM-Bildern in iCloud abgelegt wurde, wird der Account markiert und einer manuellen Untersuchung durch Apple unterzogen. Erst dann, insofern der Treffer tatsächlich positiv ausfällt, wird der Account gesperrt und ein Bericht an das National Center for Missing & Exploited Children (NCMEC) übermittelt. Es gibt Elemente im System, die sicherstellen, dass die Fehlerquote kaum der Rede wert ist – genau genommen eins zu einer Billion. Das liegt an der bereits erwähnten „Erfassungsschwelle“, die Apple nicht näher erläutern möchte. Was natürlich verständlich und auch gut so ist.

Neues iMessage-System ist sogar noch datenschutzfreundlicher

Darüber hinaus sollten wir nicht vergessen, dass der Abgleich ausschließlich in Verbindung mit iCloud-Fotos durchgeführt wird. Das heißt, wenn ein Anwender iCloud-Fotos in den Systemeinstellungen deaktiviert, bleibt das System ebenfalls ausgeschaltet. Das iMessage-System ist sogar noch datenschutzfreundlicher. Es gilt nur für Accounts, die Kindern gehören und ist damit opt-in, nicht opt-out. Außerdem erzeugt es keine Berichte, die an externe Stellen versandt werden – nur die Eltern der Kinder werden benachrichtigt, dass eine unangemessene Nachricht empfangen oder versendet wurde. Unter dem Strich bedeutet das, dass die neuen Funktionen in iCloud-Fotos und iMessage völlig unabhängig voneinander arbeiten und somit eigentlich – also technisch – nichts miteinander zu tun haben. Ihre einzige Gemeinsamkeit besteht darin, Kinder zu schützen.

- Die iCloud-Fotos Überprüfung hasht Bilder, ohne sie auf Kontext zu untersuchen und vergleicht sie mit bekannten CSAM-Sammlungen und erstellt einen Bericht, der an den Hash-Sammlungsverwalter NCMEC gesendet wird.

- Die iMessage-Funktion des Kinderkontos verwendet maschinelles Lernen auf dem Gerät, vergleicht keine Bilder mit CSAM-Datenbanken und sendet keine Berichte an Apple – nur an das elterliche Familienfreigabe-Manager-Konto.

Also lasst uns nun ein paar wichtige Fragen zum Thema beantworten. Nehmen wir mal die häufigsten Fragen, die bislang im Netz dokumentiert wurden.

Wird Apple also alle meine Fotos scannen?

Apple scannt deine Fotos nicht. Es überprüft den numerischen Wert, der jedem Foto zugeordnet ist, mit einer Datenbank bekannter illegaler Inhalte, um zu sehen, ob sie übereinstimmen. Das System sieht also nicht das Bild sondern den NeuralHash. Es überprüft auch nur Bilder, die in die iCloud hochgeladen wurden. Das heißt, das System kann keine Bilder mit Hashes erkennen, die nicht in der Datenbank enthalten sind.

Kann ich den Abgleich deaktivieren?

Wie bereits oben erwähnt, hat Apple gegenüber mehreren US-Medien bestätigt, dass das System CSAM nur in iCloud-Fotos erkennen kann. Wenn du also iCloud-Fotos ausschaltest, wirst du nicht erfasst.

iMessage: Darf ich noch Nacktfotos an meinen Partner versenden?

Wenn du volljährig bist, wirst du nicht von Apple geflaggt. Wie oben bereits erwähnt, gilt dieser Mechanismus nur für Kinderkonten und muss zuerst aktiviert werden – also opt-in. Das heißt, Apple wird dich nicht davon abhalten, Nacktfotos an deinen Partner zu versenden.

Darf ich noch Bilder von meinen Kindern in der Badewanne machen?

Auch hier haben manche Apples neue Funktionen falsch verstanden. Wie gesagt, die CSAM-Erkennung kann den Kontext einzelner Bilder nicht erkennen. Das heißt, der Mechanismus kann eine Rose von einem Geschlechtsteil nicht unterscheiden. (Ich weiß, komischer Vergleich!) Es erkennt weder das eine noch das andere. Es vergleicht lediglich die Bild-Hashes der in iCloud gespeicherten Fotos mit einer Datenbank bekannter CSAM, die vom NCMEC gepflegt wird. Mit anderen Worten, wenn die Bilder deiner Kinder nicht irgendwie in der NCMEC-Datenbank gehasht sind, dann werden sie nicht vom iCloud-Foto Scan-Mechanismus markiert.

Hilfe – Ich werde fälschlicherweise beschuldigt CSAM zu besitzen

Apples System ist so konzipiert, dass falsch positive Ergebnisse 1:1.000.000.000.000 vorkommen. Die Chance vom Blitz getroffen zu werden, liegt dabei bei 1:15.000. Selbst den Lottojackpot zu knacken ist wahrscheinlicher. Sollte also dieser unwahrscheinliche Fall eintreten, so wird eine manuelle Prüfung bei Apple eingeleitet. Spätestens dann sollte klar sein, dass es sich um einen Fehler handelt. Kurzum: Weder Bilder eurer Kinder in der Badewanne, noch Nacktbilder von euch selbst, werden einen solchen falschen Treffer erzeugen.

Welche Länder werden diese Funktionen erhalten?

Apples Kinderschutzfunktionen werden zunächst nur in den USA eingeführt. Apple hat jedoch bestätigt, dass es in Erwägung ziehen wird, diese Funktionen nach Abwägung der rechtlichen Möglichkeiten auch in anderen Ländern einzuführen. Dies würde darauf hindeuten, dass Apple zumindest einen Rollout über die USA hinaus in Betracht zieht.

Welche Geräte sind davon betroffen?

Die neuen Maßnahmen erscheinen unter iOS 15, iPadOS 15, watchOS 8 und macOS 12 Monterey, also iPhone, iPad, Apple Watch und den Mac. Bis auf die CSAM-Erkennung, die wird nur auf iPhone und iPad verfügbar sein.

Wann werden diese neuen Maßnahmen in Kraft treten?

Apple sagt, dass alle Funktionen „später in diesem Jahr“ erscheinen, also 2021. Demnach könnte das Ganze mit dem Start der neuen Software-Generation live gehen oder in einer späteren Punkt-Version aktiviert werden.

Datenschutzbedenken: Sie sind natürlich berechtigt

Trotz Apples Erklärungen und umfangreichen Angaben haben viele Anwender Datenschutzbedenken. Auch viele Kryptographie- und Sicherheitsexperten zeigen sich eher besorgt. Zum Beispiel befürchten einige Experten, dass diese Art von Mechanismus es autoritären Regierungen leichter machen könnte, gegen Missbrauch vorzugehen. Obwohl Apples System nur für die Erkennung von CSAM ausgelegt ist, befürchten diese, dass repressive Regierungen Apple dazu zwingen könnten, es so zu überarbeiten, dass es auch abweichende oder regierungsfeindliche Nachrichten erkennt. Die prominente Non-Profit-Organisation für digitale Rechte, die Electronic Frontier Foundation, merkt zum Beispiel an, dass ein ähnliches System, das ursprünglich zur Erkennung von CSAM gedacht war, überarbeitet wurde, um eine Datenbank für „terroristische“ Inhalte zu erstellen. Apple hat sich in der Zwischenzeit auch dazu geäußert und folgendes erklärt – Zitat aus einem meiner früheren Artikel:

Apples neues CSAM-Erkennungssystem wird bei der Markteinführung auf die Vereinigten Staaten beschränkt sein. Um der Gefahr vorzubeugen, dass einige Regierungen versuchen könnten, das System zu missbrauchen, bestätigte Apple, dass das Unternehmen eine mögliche globale Ausweitung des Systems nach einer rechtlichen Bewertung für jedes Land einzeln in Betracht ziehen wird.

Demnach ist nicht zu erwarten, dass das Feature irgendwann weltweit verfügbar sein wird sondern bestimmte Märkte davon ausgenommen bleiben.

Apples CSAM-System ist nicht neu

Immer wenn Apple etwas neues ankündigt, wird weltweit darüber diskutiert. Anders als viele Unternehmen genießt der angebissene Apfel besonders viel Aufmerksamkeit. Auch im jüngsten Fall. Das lässt manche glauben, dass die neuen Kinderschutzmechanismen des Unternehmens irgendwie einzigartig sind. In Wahrheit sind sie das allerdings nicht. Wie The Verge im Jahr 2014 berichtete, scannt Google seit 2008 die Posteingänge von Gmail-Nutzern auf bekannte CSAM. Einige dieser Scans haben sogar zur Verhaftung von Personen geführt, die CSAM versenden. Google arbeitet auch daran, CSAM zu markieren und aus den Suchergebnissen zu entfernen. Das ist aber nicht alles. Microsoft hat ursprünglich das System entwickelt, das die NCMEC verwendet. Das von Microsoft gestiftete PhotoDNA-System wird verwendet, um Bild-Hashes zu scannen und CSAM zu erkennen, selbst wenn ein Bild verändert wurde. Und Facebook?

CSAM-Scanning ist mittlerweile gang und gäbe

Tja, Facebook begann 2011 damit, es zu nutzen während Twitter das Ganze 2013 übernahm. Darüber hinaus wird es auch von Dropbox und ähnlichen Diensten verwendet. Ist Apple also ein Nachzügler? In gewisser Weise ja. Cupertino hat bereits eingeräumt, dass es nach CSAM scannt. Im Jahr 2019 aktualisierte das Unternehmen seine Datenschutzrichtlinien und erklärte, dass es nach „potenziell illegalen Inhalten, einschließlich Material zur sexuellen Ausbeutung von Kindern“ scannt. Apple hat das Ganze nun lediglich optimiert und damit verbessert. Während Apple als Unternehmen, das die Privatsphäre respektiert, einzigartig positioniert ist, ist diese Art von CSAM-Scanning bei Internetunternehmen also gang und gäbe – und das aus gutem Grund.

Fazit

Während die Privatsphäre ein grundlegendes Menschenrecht ist, ist jede Technologie, die die Verbreitung von CSAM eindämmt, auch von Natur aus gut. Apple hat es geschafft, ein System zu entwickeln, das auf das letztgenannte Ziel hinarbeitet, ohne die Privatsphäre der Durchschnittsperson signifikant zu gefährden. (Photo by Unsplash / Carles Rabada)